转自:硅星人

作者 | Jessica

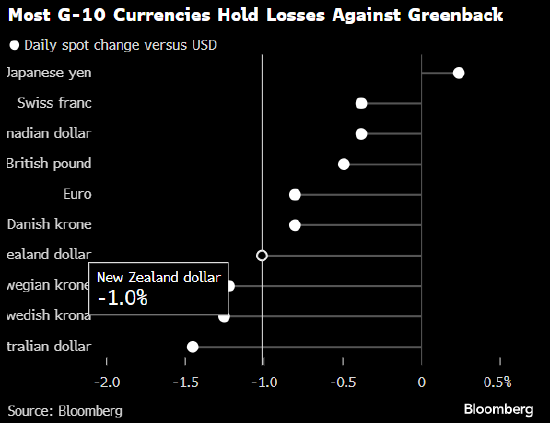

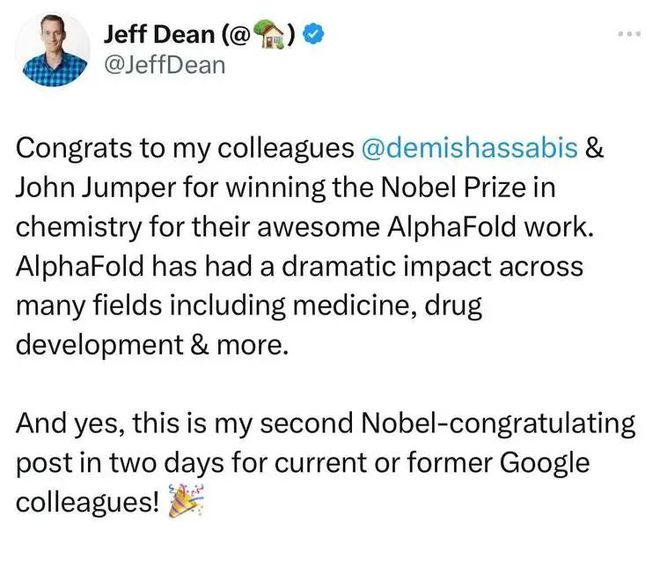

2024年的诺贝尔化学奖一半授予大卫·贝克(David Baker),“以表彰在计算蛋白质设计方面的贡献”;另一半则共同授予德米斯·哈萨比斯(Demis Hassabis)和约翰·M·詹珀(John M. Jumper),“以表彰他们在蛋白质结构预测方面的成就”。

David Baker 是华盛顿大学蛋白质设计研究所所长,被誉为蛋白质设计领域先驱。2003年起,他成功设计出全新的Top7等多种创新蛋白质,广泛应用于药物、疫苗、纳米材料、微型传感器等领域。并在1999年就提出了蛋白质结构预测算法RoseTTA,早于Deepmind的AlphaFold。

另两位获奖者就更不陌生。Demis Hassabis是Google DeepMind联合创始人兼CEO,John M. Jumper现任Google DeepMind总监。两人通过领导团队开发 AI 模型 AlphaFold 2,解决了困扰科学界50年的难题:从氨基酸序列预测蛋白质的复杂结构。

蛋白质是生命的基础化学工具,它们控制并推动着所有生物化学反应,担任激素、信号物质、抗体和组织构建的关键角色。在蛋白质中,氨基酸以长链的形式连接在一起,并折叠成三维结构。自上世纪70年代以来,研究人员一直尝试根据氨基酸序列预测蛋白质结构,无奈进展缓慢,直至四年前DeepMind带来的惊人突破。

2020年,Demis Hassabis和John Jumper在初代 AlphaFold 的基础开发了AlphaFold 2。它几乎能够预测所有已被研究人员识别的2亿个蛋白质的结构,至今已被引用超过2万次,被来自190个国家200多万人使用,在推动包括疟疾疫苗、癌症治疗、酶设计和抗生素耐药性研究等领域取得了巨大进展。实际上在诺奖以前,两人已于去年获得素有“科学界奥斯卡”之称的生命科学突破奖和“诺奖风向标”拉斯克奖,以表彰他们为基础医学研究做出的突出贡献。

瑞典皇家科学院在声明中称,“没有蛋白质,生命无法存在。如今我们能够预测蛋白质结构并设计自己的蛋白质,这为人类带来了巨大的福祉。”

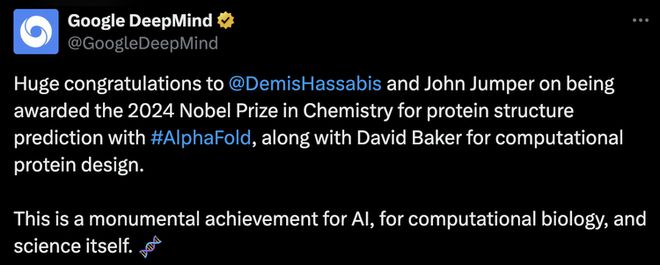

得知获奖消息后,Google DeepMind官方第一时间发文“报喜”。

Demis Hassabis也发表声明称:

“获得诺贝尔奖是我一生的荣誉。感谢瑞典皇家科学院,感谢John Jumper和AlphaFold团队,感谢更广泛的DeepMind和Google团队,以及所有为这一时刻做出贡献的同事。我将我的职业生涯奉献给AI的进步,因为它拥有无与伦比的潜力,能够改善数十亿人的生活。AlphaFold已经被200多万研究人员用于推进关键工作,从酶设计到药物发现。我希望未来我们能将AlphaFold视为AI加速科学发现巨大潜力的第一个实证。”

John Jumper随即表示:“这是AI能够加速科学研究并最终帮助理解疾病和开发治疗方法的一个重要证明。这项工作归功于Google DeepMind的优秀团队,这个奖项也认可了他们的杰出贡献。”

至此,加上此前率先获得物理学奖,并引发高度讨论度的“AI教父”杰弗里·E·辛顿(Geoffrey E. Hinton),这些今年最受关注的获奖者背后,共同的交集很明显——辛顿是承载Google早期AI野心的Google Brain的核心人物,而Demis Hassabis是承载Google近年来AI研究任务的Google Deepmind的灵魂。

怪不得连“诺贝尔派对”都直接在Google园区举办了。

在诺贝尔奖连续发给AI科学家背后,Google也“赢麻了”。

1

Google的进攻

从时间线上来看,谷歌绝对是最早入局人工智能的大公司玩家。

尽管在许多故事版本中,都将2012年冬天那场发生在美国太浩湖旁赌场酒店里的秘密竞拍,描述为Google、微软、百度三家科技巨头与DeepMind之间,围绕Hinton刚成立、除了几篇论文外没有任何实质产品的小公司DNNResearch的公平竞争。但事后回看,这场竞拍的结局其实早已注定。因为它的起源之一,正是来自6个月前Google的推动。

2012年6月,Google Brain公开启动“谷歌猫(The Cat Neurons)”项目,用算法识别YouTube视频中的猫。由吴恩达领导,Jeff Dean参与,并获得公司创始人Larry Page的大力支持。

项目构建了一个拥有10亿个连接的大型神经网络,使用来自YouTube的1000万段未标注视频,在16,000个CPU上进行训练。通过无监督学习,该系统成功自主学会了识别猫脸,准确率达74.8%,并能识别人脸等其他物体。

不过,吴恩达在项目后期选择了激流勇退,临走前向Google举荐了自己的老师Hinton接替工作。Hinton表示自己不会离开大学,只愿意去Google“待一个夏天”。就这样,他成为Google历史上最年长的实习生。

作为深度学习领域的权威,Hinton很快就意识到项目的缺陷,指出谷歌猫“运行了错误的神经网络,并使用了错误的计算能力。”于是在短暂的“实习期”结束后,Hinton马上召集学生Ilya Sutskever和Alex Krizhevsky组建团队,开发了新的神经网络架构AlexNet。并带着仅4颗英伟达GPU训练出来的成果参加了2012年ImageNet图像识别比赛,最终以84%的准确率取得颠覆性胜利。

同年10月,Hinton团队在佛罗伦萨计算机视觉会议上正式介绍了冠军算法AlexNet。一支学界团队逆袭击败硬件和研发资源对比悬殊的Google,引发学术界和产业界彻底轰动。AlexNet论文也成为计算机科学史上最有影响力的论文之一,被引次数超过12万。

接下来,三人的DNNResearch公司注册成立。后续竞拍的发展就更加顺理成章,当身价被提高到4400万美元时,Hinton叫停了拍卖,与两名学生一起正式加入谷歌,担任Google Brain副总裁和工程研究员。

当时的Hinton在一篇声明中写道:“我会继续在多伦多大学兼职任教,但在Google,我能够看到我们如何处理超大型计算。”

在直到2023年5月的十年谷歌生涯中,Hinton继续参与大规模人工神经网络研究,为Bard和ChatGPT等现代AI系统的底层技术奠定了基础性贡献。他也参与开发了开源机器学习软件库TensorFlow,推动了图像识别、语言理解等AI应用的能力提升,并将深度学习技术广泛应用于Google的各类产品和服务中。

Google对人才和技术的聚集从未放缓。在收购DNNResearch仅两年后,当年参与竞拍的对手之一, Hassabis创立的DeepMind也被它纳入囊中。

据悉,Google当时还专门包了架私人飞机带Hinton去伦敦”验货“,并且专门改造了座椅,解决他背痛不能坐飞机的问题。而当时被Google挤走的Facebook在错失DeepMind后,则转而高价挖走了“深度学习三巨头”之一的Yann LeCun。

1

Deepmind的故事

来到DeepMind这边,其实被Google收购前,DeepMind已经在财务方面遇到了困难,公司一直在烧钱,却未能找到可持续的商业模式,甚至濒临破产。

谷歌的6亿美元收购拯救了DeepMind,不仅保留了核心技术团队,还为其提供了强大的计算资源,包括云计算平台和数据中心支持。这让DeepMind能够利用更强的算力来训练深度神经网络,特别是在AlphaGo的开发中,大幅提升了计算速度和模型精度。除此之外,谷歌还提供了专门设计的TPU(张量处理单元),进一步优化了深度学习模型的训练和推理效率,AI基础工具TensorFlow也被广泛应用到DeepMind的研究之中,协助加强AlphaGo的表现。

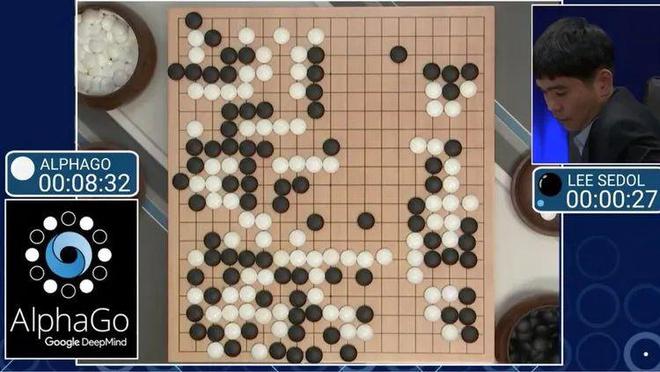

AlphaGo是DeepMind团队开发的一款人工智能围棋程序。它通过分析数百万局棋谱,用自我对弈进行强化学习,掌握了复杂的围棋策略,能够超越人类顶尖围棋选手。2016年,AlphaGo在与围棋世界冠军李世石的比赛中取得了4比1的胜利,从此一战成名,震惊全球。

然而在Hassabis眼中,通过棋盘游戏验证AI解决复杂问题的潜力只是开始。更重要的是用它来引导通用学习系统,应对现实世界的挑战,从而真正改善人类生活、革新行业并推进科学发展。

于是在几个月内,DeepMind便迅速雇佣生物学家,组建了一支跨学科团队,专注于解决蛋白质折叠难题,最终在2018年促成了AlphaFold项目诞生。经过多次迭代,AlphaFold已凭借其突破性的蛋白质结构预测能力,彻底改变了生物学研究,展现了AI在科学领域的强大应用前景。

就在今年5月,Google Deepmind再次官宣,与Isomorphic Labs联合推出新一代蛋白质预测模型AlphaFold 3,相关论文一举登上《Nature》杂志。

与之前的版本相比,AlphaFold 3不仅在蛋白质折叠预测上取得了进展,还首次实现了对蛋白质、DNA、RNA及配体等生命分子的结构及其相互作用的高精度预测。这一突破帮助科学家更深入地理解疾病机制和生命过程,同时大幅缩短了研发时间和成本。无论是开发可再生材料,还是加速药物设计和基因组学研究,AlphaFold 3都为生物分子领域打开了更广泛的应用空间。

不仅如此,团队还基于AlphaFold 3推出了一个名为AlphaFold Server的免费平台,供全球科学家进行非商业性研究,进一步推动科学探索的普及。

通过DeepMind,Google不断吸引着全球顶尖的科研人才,并提供长期的资金支持,使其能够专注于突破性研究,而不必依赖短期的商业回报。Google还赋予了DeepMind高度的战略自主权,使其能够自由选择研究方向。正是这种独立性和长期支持,为DeepMind进行前瞻性研究奠定了坚实基础。

除游戏领域和生物学突破外,DeepMind还开发了用于谷歌助手的逼真语音合成模型WaveNet,提升了语音交互体验。通过视觉-语言-动作模型RT-2增强了机器人在多样环境中的任务执行能力。其研究还涉及天气预测、核聚变反应堆等复杂问题,并通过AlphaCode和AlphaDev等项目推动了计算机算法的进一步发展。

1

Google的“家底”依然深厚

在今天的人工智能竞争中,OpenAI和Anthropic等明星公司的迅速崛起、ChatGPT、Claude之于Gemini的“碾压”,一度让人们对Google的AI策略产生了质疑。特别在生成式AI产品和开发者工具的商业化进程上,OpenAI们的快速发展与Google相对缓慢的步伐形成了鲜明对比。

然而眼前的两项诺贝尔奖似乎在提醒我们,Google深厚的科研土壤和技术积累仍是其他公司难以复制的优势。

在2006年之前,深度学习的现状可以用开尔文男爵的那句名言来概括:“深度学习的大厦已经基本建成,只不过在阳光灿烂的天空下,漂浮着三朵小乌云。”

这三朵小乌云分别是算法、算力和数据。

而Google恰恰在这些关键领域拥有明显优势。首先,它掌握了全球领先的庞大数据资源,依托YouTube、Google Scholar和Google Search等平台,Google为视觉、语音识别和自然语言处理等AI模型提供了丰富且多样化的训练数据。

其次,Google在计算资源方面具有显著优势。其自主开发的TPU硬件大大加快了深度学习模型的训练速度,Google Cloud不仅为内部研究提供了强大的计算能力,还为全球开发者提供了工具,帮助他们快速构建和部署复杂的AI应用。

在算法研发领域,Google也处于行业前沿。诞生于Google Brain团队的Transformer架构奠定了现代自然语言处理的基础,推动了今天几乎所有前沿AI模型的发展。这些技术不仅推动了学术界的进步,还广泛应用于Google的核心产品中。

2024年,AI领域依然面临着算法、算力和数据挑战。尽管许多公司也各自在某些领域有所突破,但相比之下,似乎同时具备三方面优势并持续有效结合的,还是Google。

在与OpenAI、微软等公司的竞争中,Google的“家底”依然厚实,在AI竞赛中也并未被打败。人工智能的潜力远未被充分挖掘,而在这场长跑中,或许技术创新的深度和广度才决定了最终的胜者。